Was ist ein Drittel von 12? Richtig. 4. Wenn ich also ein 12cm breites Bild habe, wo sind die Drittellinien? Richtig. Auf 4cm und 8cm. Dort sollten entweder die Grenzlinien von Bildbereichen sein, oder die Schwerpunkte von Motiven, die „Drittelregel“ zu erfüllen.

Bei 8cm Höhe liegen die Drittellinien bei 2,67cm und 5,33cm. Soweit klar?

So. Und nun gibt es eine andere Gestaltungsregel. Die heißt „goldener Schnitt“. Die ist etwas komplexer. Bei 12cm sind die senkrechten Linien bei 4,51 und 7,5. Und bei 8cm Höhe bei 3,1cm und 4,9cm. Sie sind also in der Mitte näher zusammen.

Baut man nun ein Bild nach dem „Goldenen Schnitt“, dann setzt man die Motive wieder auf die entsprechenden Linien.

Der Unterschied liegt darin, dass man beim Goldenen Schnitt nur ein Motiv braucht, bei der Drittelregel benötigt man zwingend ein Zweitmotiv für die Balance – und wenn es auch nur leerer Raum ist.

Was hat das mit KI zu tun?

KI ist ja doof. Die kann nur nachplappern, was irgendwelche Nasen im Internet vorkauen. Und da die Leute im Internet alle behaupten, dass Goldener Schnitt und Drittelregel das Gleiche sind – weil sie mit Verhältnissen von 1:1,618033988… mathematisch völlig überfordert sind – setzt auch ChatGPT die beiden Verhältnisse gleich und lobt den Bildaufbau nach Drittelregel, obwohl das Flatterviech im goldenen Schnitt ist. oder umgekehrt.

Entsprechend ist auch die restliche Bildanalyse: Da kommt Forendutzendware. Ist klar, wenn man einer KI vorsetzt, was sie kennt, spult sie das ab, was unter diesen Bildern im Allgemeinen druntersteht. Bullshit halt. Metaebenen, Insidergags oder gar politische Inhalte kann die KI nicht. Woher auch.

Wie ich da drauf komme? Ich bin in Foren und Blogbeiträgen darüber gestolpert, dass Leute ihre Bilder von ChatGPT analysieren lassen. Die Antworten wären generisch, aber man fand, man wäre froh gewesen, wenn man zu Zeiten des eigenen Anfängertums solche Bildanalysen bekommen hätte.

Nur – wenn die Bildanalyse nicht mal den Unterschied zwischen Drittelregel und Goldener Schnitt kennt, welchen Wert hat das dann? Was hilft mir eine Assistenzsoftware für das Auto, die den Unterschied zwischen gelb und rot nicht kennt?

Was passiert? Das Wissen um Bildgestaltung degradiert. Internetblödsinn wird verfestigt. Hunderttausend Forenten können nicht irren. Denn die KI weiß ja nicht, was wahr ist – sie weiß nur, was die meisten für wahr halten. Und wenn sie zu einem Thema nichts in der Wahrscheinlichkeit hat, halluziniert sie fröhlich vor sich hin.

Ich habe sie mal zu HCO befragt, der Band, mit der ich seit gut vierzig Jahren auf Tour bin. Sie hat – o Wunder – sogar die Website der Band gefunden. Über die Größe der Band weiß die KI, dass sie in den ersten zehn Jahren nur vier Mitglieder hatten. Und versieht das „Vier“ mit einem Link zum Wikipedia-Artikel der Fanta4. Zu viel der Ehre. Und natürlich stimmt das mit den vier gar nicht. Insgesamt waren es 12, wenn man die Sängerinnen vom Auftritt in Neustadt mitrechnet. Dazu muss man aber sinnerfassend und webseitenübergreifend lesen können. Die KI kann aber offensichtlich nur einzelne HTML-Seiten analysieren. Sie weiß sozusagen alles zum goldenen Schnitt, weil es da einen Wikipedia-Artikel dazu gibt. Und alles über die Drittelregel. Aber dass das zwei unterschiedliche, wenn auch ähnliche Dinge sind – das kann die KI nicht.

Sie sieht ein Bild eines Vogels, so ein Bild gibt es eine Million Mal im Netz, und muss nun nur noch wiederkäuen, was Forenten da druntergekritzelt haben. Was hat das mit dem konkreten Bild zu tun? Nichts.

Wenn wir schon dabei sind: Getty und Shutterstock versuchen sich gerade zusammenzuschließen. Beide haben durch die generative KI erhebliche Umsatzeinbußen zu verzeichnen – weil die Werbeagenturen, die früher völlig irre Summen an die Dinosaurier abgedrückt haben, auf einmal das Zeug per Prompt selber basteln. Und den Kunden ist es wurscht, weil sie ja bei Stockphotos das Zeug meistens eh nicht exklusiv haben, es also nicht um tatsächliche „Key Visuals“ für eine Kampagne geht, sondern einfach um Gebrauchsbilderkram, das sich eh keiner genauer ankuckt. Und die Kunden der Kunden der Agenturen haben den Kunden der Agenturen noch nicht deutlich zu verstehen gegeben, was sie davon halten, dass sie mit Fakes zugemüllt werden.

Getty hat gegen Stability AI geklagt, die Prozesse laufen noch. Interessanterweise hat Getty gar nichts dagegen, dass ihre Bilder für KI-Trainings verwendet werden, so wollen nur Kohle dafür haben. Stability AI hat sich gedacht – das sparen wir uns. Da es ja mittlerweile viele Klagen gegen KI-Firmen gibt wird es spannend: Wer überlebt den Hype? Sterben zuerst die Stockfoto-Agenturen, die Fotografen oder die KI-Firmen?

Oder kommt zuerst die Revolution und die Marketingabteilung der Sirius Kybernetik- Corporation wird an die Wand gestellt?

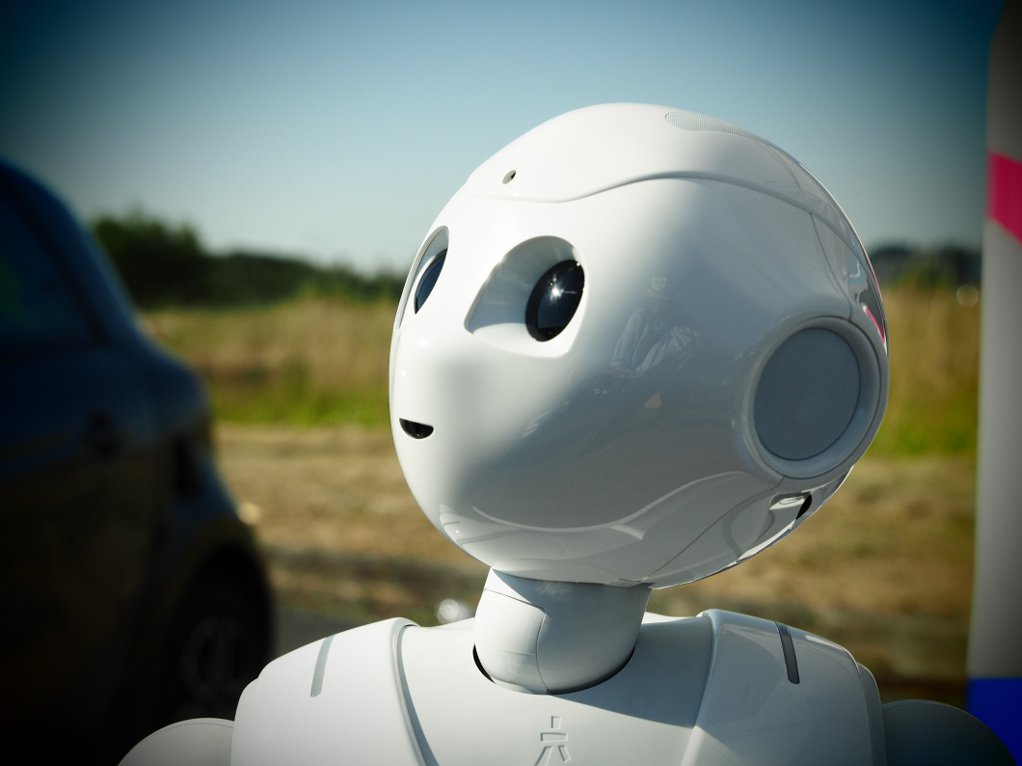

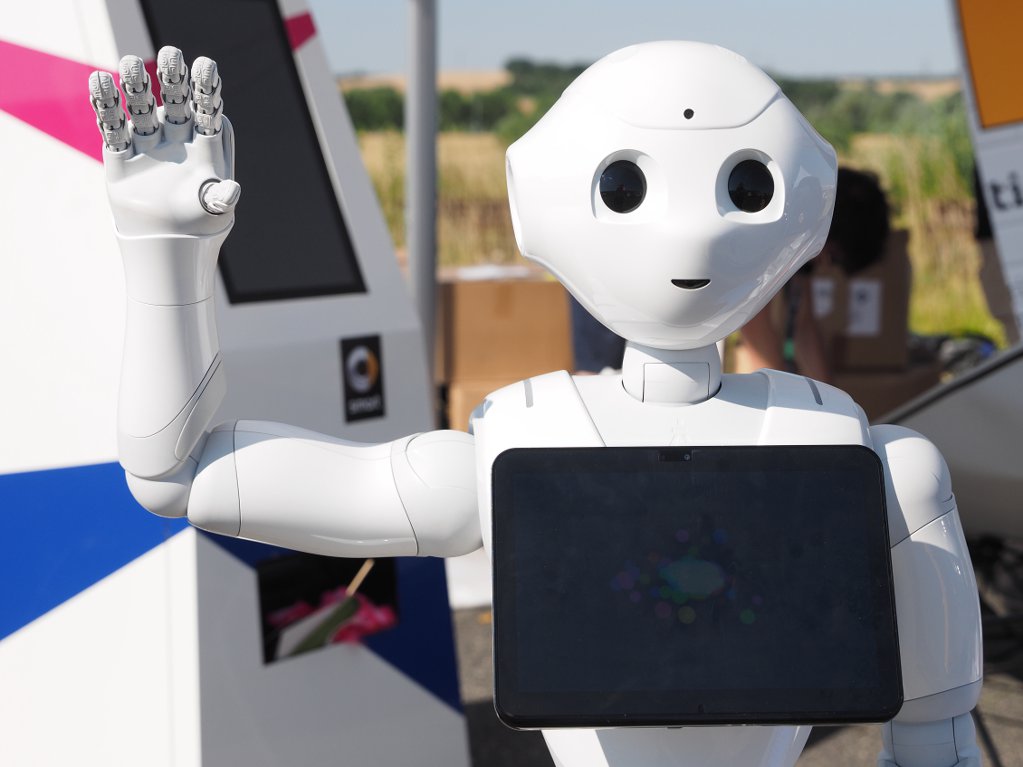

Um das zu verdeutlichen: Das Titelbild ist goldener Schnitt, das unten ist Drittelregel. Gar kein Unterschied. Nö…..

Na ja, KI ist zwar dumm, aber wenn man ChatGPT fragt:

„Wo liegen in der Fotografie die Unterschiede von goldenen Schnitt und der Drittel Regel “ bekommt man eine Recht ordentliche (und richtige) Antwort.

Zu Mathematik: da kann ChatGPT nichts, ich habe Testhalber Aufgabe des Fachabitur eingegeben, die sind alle falsch „gelöst“ worden.

LG Jörg

Das erinnert mich an Deep Thought. Die Antwort lautet 42. Aber was ist die Frage?

Auch hier: Wenn man ne Frage hat, dann findet man im Internet auch die Antwort dazu. Das Problem ist aber das Transferdenken. Man hat zehn Fakten und kann sie an einem neuen Problem anwenden. Das nennt man Intelligenz. KI kann das nicht. Sie kann kritiklos wiederkäuen. Mehr nicht.

Leider sind die Ergebnisse der KI nicht vorhersagbar, man muss selbst wissen, ob das Ergebnis richtig oder falsch ist. Warum dann die KI fragen???

Ich habe vor kurzem ein fotografisches Zitat gelesen, bei dem ich gerne gewusst hätte, von wem dieses Zitat ist. Also gegoogelt, keine Treffer. Bei ChatGPT kam die Antwort wie aus der Pistole geschossen, nur hatte ich den Namen noch nie gehört. Also nach diesem Fotografen gegoogelt, nichts brauchbares. Dann ChatGPT nochmal befragt und bang, ein neuer Name! Diesmal Henri Cartier-Bresson, das ist ein Pfund. Um sicher zu gehen meine Nachfrage an ChatGPT: Auf welchen Quellen basiert diese Info? Die Antwort ist der Hammer: es gibt keine Quellen und leider war die Info falsch. Das Zitat ist von xxx. Es täte ihr leid, dass ich falsch informiert wurde.

Also nochmal nachgefragt, auf welchen Quellen diese neue Info basiert. Jetzt grüßt das Murmeltier: Es gibt keine Quellen für xxx, aber es war auch nicht xxx sondern yyy. Es täte ihr leid, dass sie mir eine falsche Auskunft gegeben hatte.

Immerhin entschuldigt sich die KI dafür, dass sie mir eine falsche Info gegeben hatte. Gibt mir im gleichen Atemzug aber erneut eine falsche Info…

Finde den Fehler!

Der Begriff der Künstlichen Intelligenz ist ca. so problematisch wie der Begriff Vollformat. Eigentlich noch problematischer, weil ja schon Intelligenz ein weites Feld ist. Wenn man sich oberflächlich damit beschäftigt, kann man sich entspannt zurück lehnen, weil es ja gar so schlecht ist, was unter dem Namen alles verkauft wird. Befasst man sich intensiver damit, kann man teilweise nur staunen. Und ich meine nicht staunen und wundern, weil es etwa schlecht sei. Nein, es ist ein beeindruckendes Werkzeug. Wie mit jedem Werkzeug muss man auch damit umgehen lernen. Es passt nicht immer.

Es gibt zwei Sorten KI: Analytische KI und generative KI. Vielleicht sollte man in Zukunft generell von AKI und GKI sprechen. AKI ist ein sehr wertvolles Werkzeug. GKI ein energiefressender Hoax.

Auch das mit der GKI sehe ich anders. Finde ich zT sehr beeindruckend. Es gibt dort natürlich auch Müll.

Na, dann mal her mit den beeindruckenden Beispielen. Ich würde mich freuen, wenn ich mich irre und 5% der weltweiten Energieerzeugung nicht nur für Kack verblasen würden.

Kann ich Dir zeigen (Du hast ja meine eMail-Adresse, wir können uns was ausmachen), aber nicht öffentlich teilen. Dass es vom Energieaufwand und auch aus urheberrechtlicher Sicht problematisch ist, bestreite ich nicht.

Am 14.09.24 gab es im Spiegel ein (wie ich finde) interessantes Interview mit Geoffrey Hinton. Herr Hinton hat ja nicht nur die Grundlage mit entwickelt sondern hat sich auch zu einem Warner vor KI entwickelt.

Ich zitiere hier mal ein paar Sätze die ich in diesem Zusammenhang wichtig finde:

Hinton: Ein paar Leute denken, KI sei beschränkt, weil sie nur mit Daten des Internets trainiert sei. Das ist Unsinn. Superintelligente KI wird bald alle möglichen Dinge gesehen haben, die Menschen nie gesehen haben. Vor allem wird sie Analogien herstellen können, womöglich bessere als wir. Das habe ich zum ersten Mal verstanden, als ich ChatGPT fragte, warum ein Komposthaufen funktioniert wie eine Atombombe.

SPIEGEL: Entschuldigung?

Hinton: Wenn der Komposthaufen heißer wird, erzeugt er immer schneller Hitze. Wenn eine Atombombe mehr Neutronen produziert, erzeugt sie immer schneller Neutronen. Die Energieskala ist eine völlig andere, aber die zugrunde liegende Logik ist dieselbe, eine Kettenreaktion. ChatGPT hatte das verstanden. Die Frage war nur: Woher kam dieses Wissen? Ist diese Analogie irgendwo im Internet zu finden?

Das geht dann weiter, dass diese Analogie nirgendwo im Internet zu finden ist.

(von einem der Google Entwickler bestätigt)

Hinton kommt dann zu folgendem Schluss:

Die heutigen KI-Systeme sind extrem gut im Finden von Analogien. Das ist der riesige Unterschied zur KI des letzten Jahrhunderts. Damals hat man mit KI versucht, logisches Denken zu modellieren. Heute steht das Lernen im Mittelpunkt. Aber was die Maschine lernt, ist nicht ein Haufen logischer Regeln. Was sie lernt, ist am Ende eine metrische Intuition.

Tscho – und hier haben wir genau das Problem. Die Abläufe in einem Komposthaufen sind völlig andere, als bei der Kernspaltung. Weil es sich eben beim Komposthaufen eben NICHT um eine unkontrollierte Kettenreaktion handelt, sondern um einen Regelkreis der auch noch die Basis ändert. Bei niedrigen Temperaturen sind es biologische Vorgänge, bei höheren Temperaturen rein chemische Vorgänge. Genauso könnte man behaupten, das Entzünden einer Kerzenflamme sei eine Kettenreaktion ähnlich einer Atombombe. ChatGPT ist nicht „superintelligent“ sondern halluziniert da schlicht vor sich hin. Wie üblich. Aber anscheinend ist ChatGPT schon intelligenter als der durchschnittliche Spiegel-Journalist.

Das Problem ist nicht, dass die GKI intelligent wäre – das Problem ist, dass Leute glauben, sie wäre es.

Hier ein bisschen was zu Heißrotte im Komposthaufen: https://www.sbazv.de/fileadmin/user_upload/PDF/Infomaterial/Abfallflyer/Kompost/kompost.pdf

Hier noch etwas mehr: https://fryd.app/magazin/heisser-kompost

Hier gehts nicht um Mathematik per se aber um AKI.

Der Output hängt von der Eingabe ab, die Kontrolle ist schwierig, und in diesem Falle die Folgen drastisch:

https://www.infosperber.ch/gesellschaft/sozialversicherungen/schweden-frauen-arme-und-migranten-unter-ki-generalverdacht/

Es ist schwierig, ein halbwegs klares Bild davon zu bekommen was KI und insbesondere Large Language Models in der Mathematik können. Fragt man sie sehr konkrete Dinge, dann kann die Antwort schon mal richtig sein, aber ziemlich oft eben nicht, verlassen kann man sich überhaupt nicht darauf. Umso überraschter war ich als ich sah, was Terence Tao mit LLMs macht. Terence Tao ist sicherlich der produktivste Mathematiker dieses Jahrhunderts. Ich poste hier keine Links, googled einfach selbst nach „Terence Tao artificial intelligence“. Es gibt einige youtube Talks und seinen Blog in dem er oft AI thematisiert. Nur ein Beispiel: Es ging um einen mathematischen Satz, den Tao beweisen wollte. Er hat das LLM nicht gefragt „beweise mir den Satz …“ sondern „mit welchen Beweiswegen könnte man diesen Satz bewegen?“. Dabei heraus kamen (in meiner Erinnerung) sieben mögliche Beweisewege, zwei davon waren Unsinn, drei kannte Tao, die funktionierten nicht, aber mit einem der anderen Vorschläge konnte Tao den Satz dann beweisen. Wie gesagt, der ist kein Student im zweiten Semestern sondern in ganz anderen Sphären unterwegs. Die AI macht viele Fehler, auch Anfängerfehler, aber es geht hier nicht darum, sich auf eine AI zu verlassen, sondern neue Wege und Quellen zu finden.

Arbeitet jemand mit notebooklm von google? Man gibt der notebooklm AI ein Quelldokument und die generiert daraus Zusammenfassungen. Die sind erst sehr oberflächlich, aber treffen das Thema um das es geht bereits ziemlich gut. Stellt man dann spezielle Fragen zu den Texten, dann bekomt man oft qualitativ gute Antworten, zusammen mit den Textstellen, die das belegen sollen. Das ist ein hilfreiches Feature, denn man liest selbst nach, was in dem Text dazu steht. Man kann das benutzen, um Texte zu screenen, die man sonst nicht gelesen hätte, weil sie einfach zu lang sind und der „signal to noise ratio“ für das was man sucht vermutlich zu schlecht ist. Im Footer steht immer „NotebookLM kann fehlerhafte Informationen ausgeben. Bitte überprüfen Sie die Antworten.“ Ja, so ist das, aber so kann man damit arbeiten. Und das ist alles Release 1.1.

Das finde ich schon beeindruckende Beispiele. Man darf halt nicht einfach fragen und glauben, dass da etwas Korrektes bei herauskommt sondern etwas mit dem man vielleicht weiterarbeiten kann.

Zur Unterhaltung: mein „Standardtest“ für neue LLMs ist „Nenne mir die zehn wichtigsten Fotografen des letzten Jahrhunderts“ Es kommt eine Liste und man fragt „Ist es wirklich so, dass die wichtigsten Fotografen fast alle Amerikaner waren?“ (vermutlich schleppt die Menge des Trainingsmaterials den Bias mit ein). Und dann passieren meist wirre Dinge. Vielleicht kommen Sander und Gursky vor, aber in der eine neuen Liste werden z.B. einige Amerikaner zu Europäern umgewandelt werden oder es werden einfach europäische und bolivianische Fotografen erfunden, die es nie gegeben hat. Das ist alles Schrott und die Rechenzeit nicht wert.

Und genau das ist das Problem, das wir hier auch schon oft diskutiert haben. Eine KI, die im Wesentlichen Schrott erzählt – wie hier: Sieben Antworten, eine davon richtig – ist nichts wert. Wenn man Spezialist auf dem Fachgebiet sein muss, um zu erkennen, wie daneben die KI liegt, dann ist es eben die Rechenzeit nicht wert. Denn da viele Webseiten – auch ehemalige Nachrichtenmagazine – sich die Artikel von LLMs schreiben lassen und die LLMs dann den von ihnen selbst produzierten Dummfug wieder einlesen wird die Qualität in atemberaubender Geschwindigkeit schlechter. Der letzte Schutzwall zwischen dem LLM und der völligen Verdummung scheint die Wikipedia zu sein. Aber dann kann ich mir das LLM sparen und gleich in der Wikipedia kucken…..

Ein kleines Beispiel: Ich habe den Copiloten gefragt: „Was hat Sandro Rymann mit Reinhard Wagner zu tun?“ Die Antwort ist bemerkenswert: „Sandro Rymann und Reinhard Wagner sind beide in der Musikszene aktiv. Sandro Rymann ist der Head of Business (HoB) und hat in einem Blogbeitrag über die Band Seven Turns erwähnt, dass Reinhard Wagner Bass spielt “ Interessant, dass Herr Rymann neuerdings einen Blog hat, in der er über Seven Turns schreibt. Aber die KI weiß halt alles…..

Habe Reinhards Frage mal bei Aria eingegeben – Operas KI-Schnittstelle. Die Antwort war jetzt umfangreicher und klang so:

Sandro Rymann und Reinhard Wagner scheinen in verschiedenen Kontexten miteinander verbunden zu sein, insbesondere im Bereich der Technologie und Medien. Hier sind einige interessante Punkte, die ihre Beziehung beleuchten:

Veranstaltungen und Diskussionen: Sandro Rymann hat an verschiedenen Veranstaltungen teilgenommen, bei denen auch Reinhard Wagner erwähnt wurde. Zum Beispiel gab es eine offene Fragerunde, bei der Rymann als Head of Business EMEA auftrat.

Fotophonie und Medien: Rymann war kürzlich in einer Diskussion über Fotophonie aktiv, wo er auch über Themen sprach, die mit Reinhard Wagner in Verbindung stehen. Dies zeigt, dass sie möglicherweise in ähnlichen Fachgebieten tätig sind oder sich mit ähnlichen Themen auseinandersetzen.

Community-Interaktionen: In der OM-System Community gab es Diskussionen, in denen sowohl Rymann als auch Wagner erwähnt wurden, was darauf hindeutet, dass sie in einem gemeinsamen Netzwerk oder einer Community aktiv sind.

Es scheint also, dass ihre Verbindung vor allem durch berufliche und fachliche Interaktionen geprägt ist. Gibt es einen bestimmten Aspekt ihrer Beziehung, der dich besonders interessiert?

Das mit der Fotophonie dürfte eine Diskussion mit Dieter Bethke meinen und ist so wie es geschrieben wurde zumindest nicht sehr präzise – aber wie Boris geschrieben hat, ich hätte jetzt Ansatzpunkte, um weiter zu forschen. Allerdings bin ich nicht sicher, ob dazu nicht eine einfache Suche über eine Suchmaschine (möglichst eine, bei der man sich nicht zunächst durch zig „gesponsorte“ Ergebnisse arbeiten muss) genauso geholfen hätte.

Viele Grüße

Joachim

Man kann mit gutem „Prompten“ wirklich einen signifikanten Unterschied bei GKI erzielen. Wie man gute GKI Prompte macht, kann man mit AKI lernen…

Interessante Diskussion.

Ob die generative KI nur Mist produziert, oder eine Modeerscheinung ist, die wieder verschwindet, darüber reden wir vielleicht besser nochmal in 10 Jahren.

Da fragen wir dann mal die arbeitslosen Schundromanschriftsteller, die arbeitslosen Dutzendware Drehbuchautoren, die Produktefotografen, die heute schon schon dank Rendering zu beissen haben usw.

Ein echter Fotokünstler wird sich wohl keine Sorgen machen müssen, aber alle anderen…

Ist wie bei Möbel: ein paar wenige produzieren sehr teure handgefertigte Möbel für gut betuchte, der Rest kauft bei Ikea oder dem Billigdiscounter Massenware.

Was wir heute an GKI sehen, ist erst der Anfang. Ein Kind läuft auch noch wacklig nach seinen ersten Schritten, aber macht exponentielle Fortschritte und rennt in Kürze umher.

Ist wie beim autonomen Fahren: ja, schon lange wird davon gesprochen und Zweifler spotteten schon, weil die Entwicklungskurve laaaange sehr flach war, nun zieht die Kurve langsam nach oben und es fahren die ersten Autos offiziell autonom in Städten. Noch etwas wacklig, aber schauen wir doch mal, ob wir in 10 Jahren auch noch darüber lachen…

Du sprichst da interessante Dinge an: Die Groschenromanschriftsteller: Ich bezweifle, dass eine GKI auf absehbare Zeit eine gut laufende Perry-Rhodan-Serie zuwege bringt. Dem Kunden fällt das auf. Yellow-Press-Produkte sind auch so ein Thema. Da kann die GKI zwar problemlos massenweise Dummfug halluzinieren, aber es ist halt dann blöd, wenn die Zeitschrift dann eben massenweise Klagen an den Hals kriegt. Drehbücher werden heute bereits per GKI geschrieben, entsprechend werden die Filme immer schlechter und die Kinoeinnahmen gehen zurück. Viele Filme werden deshalb nur noch über Streaming vertrieben, da ist es ziemlich egal, ob sich das noch wer ankuckt, weil die Studios nicht über pay-per-View bezahlt werden. Und die Produktfotografen – jo – alles, was als CAD-Daten vorliegt wird schon lange nicht mehr fotografiert. (Da bin ich schon vor 15 Jahren bei einem Kunden rausgeflogen, weil die ihre Bauteile nur noch gerendert haben. Die restlichen Fotos, die ich damals gemacht habe, verwenden sie aber heute noch für ihre Firmenkommunikation.) Die GKI wird hat das große Problem, dass sie irrsinnig Geld und Energie kostet und derzeit nur deshalb so einen Hype hat, weil die Leute nahezu kostenlos angefüttert werden. Sobald die KI-Firmen ernsthaft Geld verdienen müssen, ist der Fotograf nämlich wieder billiger. Gerade Waymo – die autonomen Taxis – ist da ein schönes Beispiel: Die Taxifahrt mit Waymo ist teuerer als mit Uber. Es funktioniert nur in einer Stadt, für die es laufend aktualisierte zentralisierte Pläne gibt, da ein Waymo-Car mit einem Schild „Durchfahrt verboten – Baustelle“ nichts anfangen kann. Letzthin gab es ein schönes Video, wo ein Waymo-Car einen Lieferroboter angefahren hat. Weil das Car nicht erkannte, dass das auch so ein autonomer Blechdepp ist, der sich bewegen kann. Und trotz allem verbrennt Waymo im Jahr 2 Mrd Dollar. Apple hat es übrigens eingesehen und sein autonomes Apple-Car eingestampft. Es gibt ein lustiges Video von Waymo-Cars, die versuchen, nachts auf ihrem eigenen Parkplatz einzuparken und sich dabei gegenseitig lustig anhupen. Jede Nacht. Sehr zum Gaudium der Anwohner. Und Autonome Fahrzeuge sind noch nicht mal GKI sondern AKI.

Ja Reinhard, der Leser wird bei Perry Rhodan den Unterschied „noch“ bemerken. Ebenso bei einem Jerry Cotton Roman.

Und ja, ich schrieb ja: wir lachen über die Taxis.

Aber tun wir dies noch in 10-15 Jahren?

Ich bezweifle es. Aber dies ist eben die spannende Frage.

PS: Apple war einfach zu spät dran. Die werden sich einfach irgendwann irgendwo einkaufen. Wäre ja nicht das erste Mal.

Wir werden sehen. Auf jeden Fall nicht langweilig. 🙂

Das ist eben die Frage. man überlege sich, was vor 15 Jahren der Hype war. Digitalfotografie. Die Prognosen gerade bei spiegellos gingen nur nach oben. Olympus peilte die Marktführerschaft an. (Ich habe die PP-Präsentation damals gesehen..) Facebook, Insta, Second Life. Dann kam das Metaverse. Alles mittlerweile tot oder am absteigenden Ast. Selbst Google geht jetzt den Bach runter, die Suchergebnisse werden von Google künstlich verschlechtert, um mehr gesponserte Suchergebnisse anzeigen zu können. Die Gier frisst das Hirn. Der Chef von OpenAI will, dass die Chiphersteller mal schnell für 4 Billionen Dollar (nicht amerikanische Billionen.) Chipfabriken aus dem Boden stampfen. Frage an Altmann, wie er jemals damit Geld machen will: „Wir bauen erst mal eine tolle KI, und dann fragen wir sie, wie wir dafür sorgen, dass unsere Investoren Rendite bekommen.“ Jeden Cent dieser Rendite müssen aber die Endverbraucher rausrücken. Warum sollten sie das tun? Die Auflagen der Regenbogenpresse haben sich in zehn Jahren halbiert. Wo soll das Geld herkommen, damit sich das Zeug irgendwann rentiert? Noch dazu, wenn KI-Erzeugnisse nicht mal Copyright haben! Wie will man mit Perry-Rhodan-Texten Geld machen, wenn sie jeder gratis kopieren kann? Und sobald Copyright drauf ist, ist das Zeug wieder so teuer, dass der menschliche Output billiger ist.

„Wir bauen erst mal eine tolle KI, und dann fragen wir sie, wie wir dafür sorgen, dass unsere Investoren Rendite bekommen.“

Na wenn das mal nicht nach Deep Thought klingt …. aber dann kann man sich den Aufwand sparen, die Antwort ist doch schon bekannt 😀

Andy

imsorrykonnteichmirnichtverkneifenmodus

Gerade im letzten Abschnitt schneidest Du Fragen an, die extrem spannend sind.

Ich habe keine Antworten darauf und weiss (wie wir alle) nicht, wohin das führt.

Ich habe aber ein paar Ideen und die machen mir mulmige Gefühle…

Abomodelle z.B. werden sich weiter verbreiten. Mittlerweile braucht man teilweise schon Abos zu bezahlen, um die Spezialprogramme bei Geschirrspülern verwenden zu können. Beim Geld verdienen waren die grossen Unternehmen schon immer kreativ. Notfalls nimmt man noch das Steuergeld der Bürger, um neue Firmen zu subventionieren.

Das könnte böse enden… (siehe die politischen Entwicklungen in z.B. DE, A, USA, F, ITA. Die Liste kann man ziemlich lange weiterführen. Oder die Entwicklung bei den Fake News.)

Ich halte KI abseits von Mustererkennung für eine Fehlentwicklung. Wenn dann will ich ein Expertensystem für ein konkretes Gebiet, bei dem Ich weis, auf welcher Datenbasis es arbeitet, und sich dabei um validierte Daten handet. KI-Systeme, die mit Internetcontent trainiert wurden sind bestenfalls so dumm wie der durchschnittliche Internetcontent, und das ist ziemlich bescheiden. Meine Tests mit Chat GPT waren bislang nicht besonders berauschend.

Als ich eine botanische Information abgerufen hatte, hat mir der Bot eine Liste von 10 Arten als komplette Antwort aufgelistet. Als ich dann beharrlich nachgehakt habe, hat er dann doch noch 30 weitere in den Tiefen seiner Daten gefunden….

Krasser fand ich, als da derletzt so ein trauriges Schauspiel im Thüringer Landtag bei der Wahl dessen Präsidenten abgezogen wurde. Da dachte ich statt selbst zu Suchen, frage ich einfach mal Chat GPT nach der aktuellen Version der Verfassung des Landtags. Diese hat er mir prompt gelfiert, soweit okey, dann aber leider noch gemeint er müsste mir gleich erklären was da drin steht, und das war einfach Falsch. Was er mir erklärte gilt zwar oft -z.B. bei Wahl des Bundespräsidenten – aber leider nicht bei der Wahl des Thüringer Landtagpräsidenten….

Als ich darauf hingewiesen habe, hat er zuerst auf sein Allgemeinwissen bestanden, und sogar falsch mit den Einzelnen Abschnitten des relevanten Artikels referenziert. Als ich das dann durchgekaut habe, hat er sich am Ende korrigiert und entschuldigt.

Aber eine KI, welche einen Gesetzestext zwar korrekt findet, dann aber mit abweichenden Allgemeinplätzen falsch interpretiert ….. das war irgendwo zwischen surreal und Orwell, wenn man bedenkt wie kritiklos KI teilweise genutzt wird.

Und genau das ist halt das Problem. Du weißt nicht, ob das, was da als Antwort kommt, korrekt ist oder daherphantasiert. Wenn Du es beurteilen kannst, brauchst Du die Antwort nicht, wenn Du es nicht beurteilen kannst, nützt Dir die Antwort nichts. Es wird die Zeit kommen, in der ein gedruckter Brockhaus wieder eine gesuchte Quelle sein wird.

„Ich halte KI abseits von Mustererkennung für eine Fehlentwicklung. Wenn dann will ich ein Expertensystem für ein konkretes Gebiet, bei dem Ich weis, auf welcher Datenbasis es arbeitet, und sich dabei um validierte Daten handet. KI-Systeme, die mit Internetcontent trainiert wurden sind bestenfalls so dumm wie der durchschnittliche Internetcontent, und das ist ziemlich bescheiden“ – Völlig richtig. Die Sache ist halt die, das Expertensystem ist teuer, weil es mit menschlicher Arbeit aufgebaut werden muss. Die KI ist – abgesehen aktuell noch von den Betriebskosten – billig, denn der braucht man nur einen Haufen „Big Data“ hinwerfen, und damit „trainiert“ sie sich selbst.

Wie bei fast jedem anderen „Fortschritt“ geht es hier auch nur darum, 1. teure menschliche Arbeit überflüssig zu machen, und 2. die monetären Erträge nicht der Allgemeinheit zugute kommen zu lassen, sondern den Privateinkommen der Firmeneigner. Dass das Ganze irgendeinen echten Nutzen hat, ist nebensächlich.

Interessant wie die Diskussion mäandert.

Ich möchte mal ein paar Gedanken in den Ring werfen: Ihr mischt alles was als KI bezeichnet wird in einen Topf.

1. KI ist eigentlich Machine Learning. Das funktioniert im Moment prima bei Mustererkennung und ansatzweise zum sortieren von riesigen Datensätzen, Stichwort Big Data.

2. Das ganze Machine Learning ist seit gut 10 Jahren ein Thema, in der Wissenschaft etwas länger. Ergo, die ganze KI Technologie steckt immer noch in den Kinderschuhen. Die „KI“ macht sozusagen gerade die ersten wackligen Schritte bei generativen Inhalten.

Ein kleines Praxisbeispiel:

Ich bin Tontechniker und arbeite parallel als technischer Supporter für naturwissenschaftliche Forschung. 2010 startete ich mit einer Doktorin in Biologie ein Forschungsprojekt um Orang Utans im Regenwald zu observieren.

Kurzer Projektbeschrieb: In zwei Regenwaldgebieten in Borneo und Sumatra wurden je 25 autonome Audiorecorder in einem Grid im Wald installiert. Die Recorder wurden per Solarpanel gespiesen, hatten ein Mikrofon in den Baumkronen und einen GPS Sensor per Schnittstelle angebunden. Die Recorder nahmen über mehrere Jahre 24/7 Audiodaten auf.

Datenauswertung: Wenn ein beliebiger Orang Utan einen Laut gibt (Long Call), wird der Ruf auf mehreren Recordern aufgezeichnet und dank Atomzeit und genauer Position der Recorder per GPS Sensor kann man über die Schalllaufzeiten die genaue Position des rufenden Tieres bestimmen. Weiter kann dank Stimmerkennungsalgorythmen das Individuum bestimmt werden („Karl hat gerufen an Position X und Rolf auf Position Y hat geantwortet“.)

Weiter kann man damit Hochrechnungen machen, wieviele Tiere sich im Gebiet bewegen. Usw.

So. Als ich 2010 die ersten Recorder Prototypen baute gab es noch keine Software, die man auf ein Tier trainieren konnte, um das Tier in einer Audioaufnahme zu zu finden. Zur Erinnerung: wir produzieren pro Jahr 50 Jahre Audioaufnahmen. Keine Chance also dies manuell zu kontrollieren.

Um Tiere per Stimmerkennung zu identifizieren (Individuum) mussten mir noch das Audiofile manuell in speziellen Messprogrammen (Spektrogramm) ausmessen.

Parallel entwickelte meine bessere Hälfte und zwei weitere Wissenschaftler einen Machine Learning Algorithmus, der Orang Utan Stimmen selbstständig in Audioaufnahmen findet und in einem weiteren Schritt Stimmerkennung des Individuums.

Mittlerweile kann ich die Audiofiles in die Datenbank laden und die Software rattert mal ein Bisschen und markiert extrem genau alle Orang Utans und identifiziert sie perfekt und rechnet automatisch die Positionen aus.

Mittlerweile arbeiten wir an einer universellen Schnittstelle die auf jegliche Geräusche trainiert werden können. Praxisbeispiel: ein Grid von Smartphones, die in einem Naturschutzpark installiert sind, erkennen selbstständig Schüsse und Autogeräusche und alarmieren automatisch inkl. GPS Position die Wildhüter per SMS. Funktioniert noch nicht extrem gut, aber dank der „KI“ Kerne moderner Smartphones werden wir innerhalb der nächsten 2-3 Jahre soweit sein, dass es in der Praxis eine genug hohe Trefferquote hat. Nicht zu vergessen: die Daten werden in Echtzeit im Smartphone berechnet, nicht in einem dicken Superrechner, denn so haben wir 2010 angefangen. Dies auch zum Thema Stromverbrauch und steigende Effizienz…

Noch ein paar kleine Beispiele:

1. Ich habe hier eine Audiosoftware die bei 0815 Pop und Rocksongs einen fertig gemischten Song in Stereo wieder aufsplitten kann in Drums, Bass, Gesang, Bläser, Keyboards. Man kann also einen beliebigen Song nehmen und ihn selber neu mischen. Das funktioniert mittlerweile extrem gut und mit Erfahrung eingesetzt ohne hörbare Artefakte.

2. Ich habe eine Software die aus komplexer Musik die Gesangsstimme komplett rausfiltern oder isolieren kann.

3. Jeden Tag werden auf Spotify mehrere Tausend neue Songs hochgeladen die komplett mit generativer KI komponiert wurden. Zugegeben, meistens simple Techno- und Popmusik, aber ich wette um eine Olympus Kamera, dass die meisten Leute nicht erkennen würden, dass die Songs KI generiert sind.

4. Der Zürcher Tagesanzeiger benutzt seit zwei Jahren eine Software, die die Sportbilder sichtet und für die Bildredaktion Bilder vorselektiert.

5. Es gibt mittlerweile Software da brauche ich 2-3 Minuten Audiosignal von einer eurer Stimmen. Nach kurzer Analyse kann ich euch jeden beliebigen Text vorlesen lassen, inkl. Atmer und in Grenzen sogar mit bestimmten Emotionen und eure Freunde würden beim Blindtest nicht merken, dass es die generative KI gesprochen hat. Video geht noch nicht zufriedenstellend, aber funktioniert in Ansätzen schon. In 10 Jahren werden wir wohl überschwemmt werden mit generativ erstelltem Videocontent. Stichwort Fake News… Auch Schauspieler werden hartes Brot essen…

Uswusf…

Fazit: Reden wir in 10-15 Jahren nochmal über das Thema, dann werden wir sehen was langfristig funktioniert und was nicht, aber ich bin überzeugt wir würden alle Bauklötze staunen, wenn wir 15 Jahre in die Zukunft sehen könnten.