Alle Jahre wieder – kümmert euch um eure Backups. Ich habe vor drei Tagen im Fundus eine CF-Karte gefunden, auf der noch Fotos von 2014 drauf waren. Klar, die hatte ich längst mehrfach gesichert. Aber ich war doch etwas erschrocken, was die Zeit aus diesen Daten gemacht hat.

Zugegeben, die Bilder haben noch Luft nach oben, aber ich dachte anno 2014 nicht daran, dass ich auf der Karte meine Knüllerfotos lagere um acht Jahre später zu kucken, ob sie noch intakt sind.

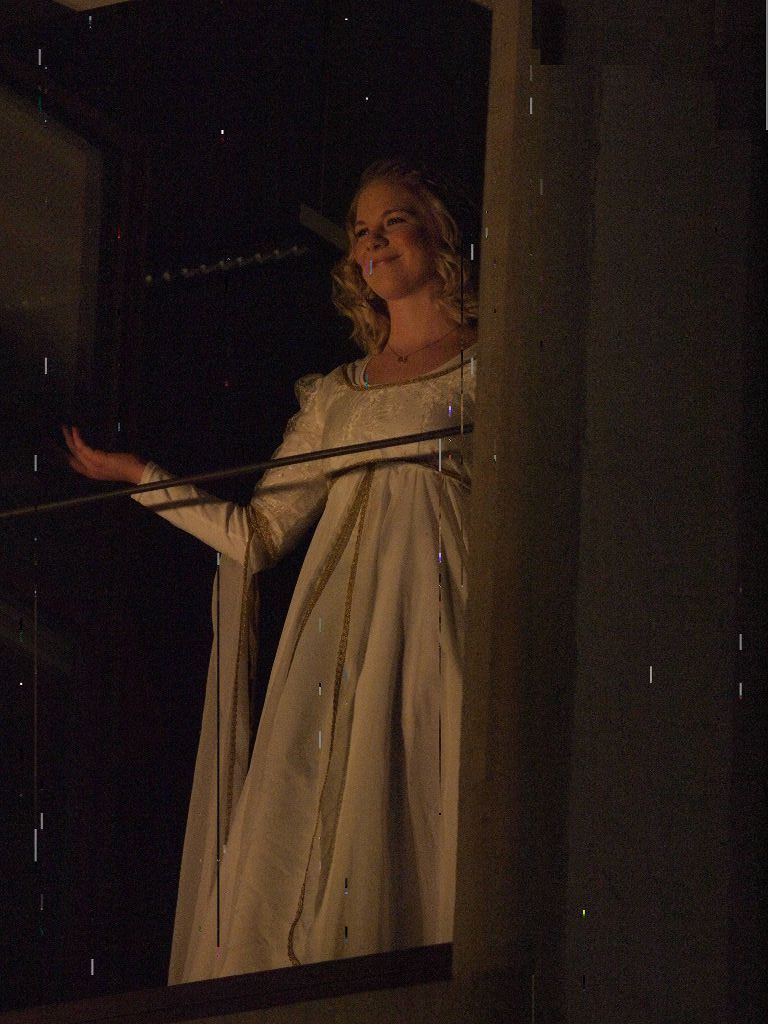

Das oben ist ein Foto aus der Serie, wie ich sie auf meiner Festplatte habe.,

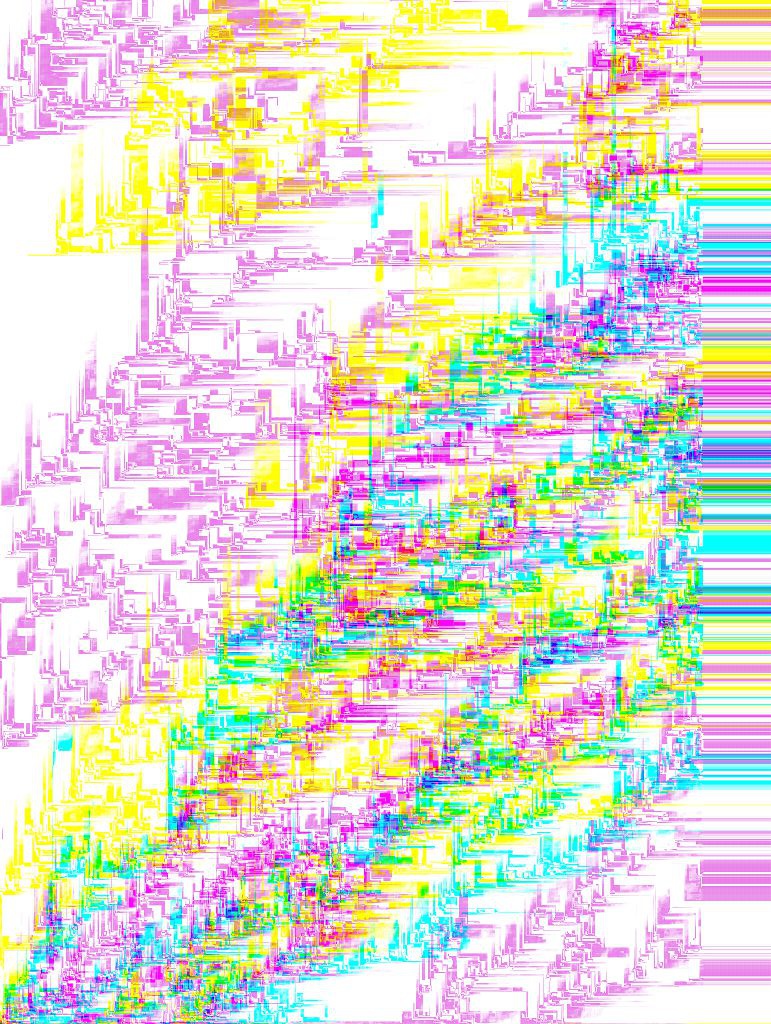

Das hier ist ein JPG aus der Serie von der CF-Karte. (Eine Transcend 8GB)

Und das hier das RAW, wie es Picasa sieht.

Ich hätte hier noch ein JPG, das ein bisschen verschubst ist,

Und so sahen die meisten JPGs aus:

Also: kopiert das Zeug von den Flash-Speichern runter und sichert es doppelt. Die Idee, mit einer Tüte voll SD-Karten in den Urlaub zu fahren und die dann erst nach der Heimkunft auf den PC zu spielen, kann nach hinten losgehen. Flash-Speicher sind keine Backup-Medien.

Und nur um das klarzustellen: Auf der CF-Karte habe ich gerade eben frisch fotografiert – die funktioniert prima. Es handelt sich also nicht um eine defekte Karte! Die Langzeitstabilität der einzelnen Speicherzellen ist aber eben nur so mittelgut.

Wenn ich es richtig dunkel in Erinnerung habe liegt das an der Physik der Speicherzellen, die ja “nur” eine begrenzte Zeit ihre Ladung halten können…

Gibt es dafür eigentlich irgendwelche Kenngrößen? Halbwertzeiten oder so?

Peter kann dazu doch bestimmt was erzählen?!

neujährliche Grüße,

der Kleine Physiker

Danke für den Artikel und insbesondere für die Bilder. Das sich das so auswirkt, habe ich bisher nicht gesehen. Ich war immer davon ausgegangen, dass die Daten bei Flashspeicher einfach nicht mehr sinnvoll lesbar sind. Gekippte Bits hätte ich eher bei Festplatten erwartet.

Das bestätigt, dass Flashspeicher wie zB auch SSDs ab und zu Strom brauchen, sonst können Daten verloren gehen. Auch CDs oder DVDs, die zwischenzeitlich ja auch als Backup Medien verwendet wurden, halte nur wenige Jahre. Am längsten halten noch HDDs, auch weil sie in der Regel langsam kaputt gehen, aber und auch dann sollte man seine Daten regelmässig umkopieren.

Und das Backup sollte regelmäßig überprüft und auch wiederhergestellt werden. Denn das beste Backup nützt nichts, wenn man nicht an seine Daten kommt, wenn man sie braucht.

“Ich war immer davon ausgegangen, dass die Daten bei Flashspeicher einfach nicht mehr sinnvoll lesbar sind.”

Naja, der Controller der CF-Karte muss entscheiden, ob an der betreffenden Stelle eine 0 oder eine 1 gespeichert ist. “Keins davon” ist als Ergebnis nicht wirklich vorgesehen, also kann es sein, dass der Controller in seiner Verzweiflung die falsche Wahl trifft.

Das Problem für die langfristige Haltung einmal geschriebener Daten (“retention” genannt) ist, dass sich mit der Zeit die Elektronen aus den Transistoren der Flash-Zellen verzwitschern und die Zellen nicht mehr eindeutig gelesen werden können. Das gilt für CF-Karten natürlich genauso wie für SD-Karten, die letztlich auf denselben Prinzipien beruhen – nur der Formfaktor und die Ansteuerung sind anders. Die “retention” ist außerdem temperaturabhängig; je wärmer die Karte, desto schlechter. Heutige Flash-Medien sind typischerweise auf eine Retention von 20 Jahren bei 55°C ausgelegt (eine Temperatur, die im Inneren eines elektronischen Geräts durchaus erreicht werden kann, auch wenn es sich außen noch nicht unangenehm heiß anfühlt). Bei niedrigeren Temperaturen – etwa wenn das Flash-Medium nur irgendwo rumliegt – ist die Retention grundsätzlich länger, wobei es natürlich immer um Durchschnittswerte geht und keine garantierten Minima und außerdem auch andere Effekte (etwa kosmische Strahlen) Flash-Zellen “kippen” können. Gerade Datenformate wie JPEG sind sehr anfällig gegenüber gekippten Bits, so dass auch kleine Veränderungen mitunter sichtbaren Schaden hervorrufen können. Das Risiko für sowas ist im kurzfristigen Gebrauch sehr gering und läßt sich weiter minimieren, etwa durch paralleles Schreiben auf zwei Medien in einer entsprechend ausgerüsteten Kamera, aber steigt natürlich an, wenn man das Medium lange unbenutzt herumliegen läßt.

Man sollte sich auch nicht darauf verlassen, dass es reicht, eine ältere CF-Karte hin und wieder für eine Weile mit Strom zu versorgen, damit die Flash-Zellen wieder “aufgefüllt” werden. Wenn man sichergehen möchte, muss man selber die Daten von der Karte runterkopieren, die Karte löschen und die Daten dann wieder frisch draufkopieren. Es gibt inzwischen Flash-Controller, die, wenn sie nichts Besseres zu tun haben, ansonsten dumm herumliegende Flash-Zellen auffrischen, aber die sind in billigen Medien wie CF- oder SD-Karten eher nicht zu finden, sondern kommen bei SSDs zum Einsatz.

Übrigens, CF-Karten, jedenfalls die älteren, sind von ihrer Ansteuerung her im Prinzip IDE-Festplatten (mit einem FAT-Dateisystem). Man kann also oft die für viele Betriebssysteme verfügbaren S.M.A.R.T.-Werkzeuge zur Festplatten-Diagnose verwenden, um sich einen Überblick über den “Gesundheitszustand” der Karte zu verschaffen, etwa wie viele Speicher-Blöcke bereits als schadhaft bekannt und intern durch andere aus der Geheimreserve ersetzt sind (wenn die Geheimreserve aufgebraucht ist, ist die Karte reif für die Tonne).

Auf der Karte waren auch Bilder von 2018 (von einem FolyFos in Rocksdorf) – die waren durch die Bank noch OK.

Danke für die ausführliche Erklärung und die Details, wie Flashspeicher arbeiten. Manches war mir bekannt, aber nicht alles . Und meine Annahme war anscheinend auch zu kurz gegriffen. Ich war davon ausgegangen, dass Flashspeicher wie SSD eher schnell unbrauchbar werden, während HDDs eher langsam kaputt gehen. An einzelne Bitkipper hatte ich so direkt nicht gedacht. Ich war auch eher davon ausgegangen, dass Zellen als Ganzes ausfallen. Aber selbst dann ist ja auch nicht unbedingt die ganze Datei unbrauchbar.

In jedem Fall spricht das alles dafür, die Daten möglichst zeitnah zu kopieren und anschließend nochmals als Teils des Backups zu sichern. Und am besten dafür noch magnetisch-speichernde HDDs verwenden.

Über die langfristige Retention von (modernen) SSDs ist noch relativ wenig bekannt, weil es die einfach noch nicht lange genug gibt. Für die SSDs spricht, dass sie keine beweglichen Teile haben, die kaputtgehen, verharzen oder dejustiert werden können. Sie sind mit einiger Sicherheit auch zuverlässiger als CF- oder SD-Karten. Es ist aber sicher kein Fehler, Backups (auch) auf “spinning rust” zu machen, denn das ist wenigstens einigermaßen verstanden.

(Für Sachen, die wirklich wichtig sind, kommt natürlich auch – verschlüsselter – Cloud-Speicher in Frage, jedenfalls sofern es sich nicht um gigantische Datenmengen handelt und man überzeugt ist, dass der betreffende Anbieter nicht liederlich arbeitet und sich seinerseits um angemessene Redundanz bzw. Backups kümmert.)

Schließlich: Heutige Flash-Medien speichern in der Regel mehr als ein Bit pro Zelle, typischerweise 2 bis 4. Das macht die Sache natürlich nicht besser; wenn die Zelle nicht mehr verlässlich lesbar ist, sind dann halt noch mehr Bits falsch.

Es gibt keinen sicheren Cloud-Speicher. Und keine sichere Verschlüsselung. Wenn es sie gäbe, wäre sie verboten.

Naja, das Thema hatten wir hier ja schonmal. Grundsätzlich gibt es sehr wohl sehr sichere Verschlüsselungsverfahren, bei denen man schier ewig bräuchte, um sie zu knacken, solange man dafür keine Quantencomputer einsetzen kann. Daran erkennt man schon, daß es vom jeweiligen Standpunkt abhängt, was nun sehr sicher ist und was nicht. Man muß die Sache eben differenzierter sehen. Man muß auch nicht unbedingt die Verschlüsselung an sich knacken, um an verschlüsselte Daten ranzukommen. Was geht und was nicht, hängt vom Anwendungsfall ab. Wenn man Daten lokal verschlüsselt und dann auf einen Server lädt, fallen die meisten Angriffsmöglichkeiten weg, weil die an der Verschlüsselung beteiligte Hardware nicht mehr im Spiel ist. Da geistert der Schlüssel nicht mehr in irgendeinem flüchtigen Speicher herum, und die Daten liegen auch nirgends entschlüsselt herum, wie es der Fall ist, wenn deren Besitzer gerade damit arbeitet. Dann kann man vermutlich nur noch versuchen, den Schlüssel zu erraten, was mit aktuellen Technologien eben mit hoher Wahrscheinlichkeit extrem lange dauert, oder einen Fehler in der Verschlüsselung zu finden, mit dem man den Schlüssel wiederherstellen kann, wenn das überhaupt geht. Und dann gibt es ja auch noch hardwareseitige Verschlüsselung.

Diese sehr allgemeine Behauptung, es gebe keine sichere Verschlüsselung, finde ich jedenfalls einfach nicht in Ordnung. Absolute Sicherheit, also eine Wahrscheinlichkeit von wirklich 100%, gibt es eben nirgends. Man muß sich überlegen, was man in der einen oder anderen Situation braucht.

Unternehmen wie mailbox.org und Signal würde ich relativ weit vertrauen, solange die Rechtslage nicht so weit entartet, daß sie sich nicht mehr gegen behördliche Daten-Langfinger wehren können. Aber über die Chat-Kontrolle, die die EU einführen will und die vermutlich so eine Entartung darstellt, spricht in der Öffentlichkeit irgendwie fast niemand. Momentan ist Signal so programmiert, daß das Unternehmen dahinter fast keine Daten sehen kann, nur die wirklich für den Betrieb notwendigen. mailbox.org hat sich vor ein oder zwei Jahren über den Brand in einem Rechenzentrum im Elsaß (?) ausgelassen und beschrieben, was sie anders machen, damit sowas nicht passiert bzw. im Falle eines Brandes nicht gleich viele Daten endgültig weg sind. Aber auch da muß man hinreichend differenziert hinsehen. Am Ende muß jeder selbst entscheiden, was er braucht oder will.

Da fällt mir ein, ich hatte mal ein Benutzerkonto in einem Forum, und dort ein Benutzerbild, das links neben meinen Beiträgen angezeigt wurde. Nach vielen Jahren der Abwesenheit habe ich mit einer bekannten Suchmaschine nach irgendetwas gesucht und einen meiner eigenen, alten Beiträge in diesem Forum gefunden. Das Benutzerbild daneben war total kaputt, ähnlich wie die Beispiele oben. Das Bild war vermutlich in einer Datenbank auf einem Server gespeichert.

Es tut mir leid, Dir widersprechen zu müssen. Es gibt keine sichere Verschlüsselung. Es wird gerade an einer entwickelt, die mit aktueller Technik erst in mehreren Jahrzehnten geknackt werden knnnte. Theoretisch, so in diese Technologie keine Backdoor eingebaut wird. Derzeit laufen Bestrebungen, genau diese Backdoor zu etablieren. Die Verschlüsselungstechnologie, die derzeit Endkunden zur Verfügung steht, hindert Regierungsstellen an gar nichts. Verschlüsselung würde nur dann etwas helfen, wenn wirklich jeder jede Kommunikation und alle Daten hochsicher verschlüsseln würde. Dann würde die Rechenleistung selbst des größten Serverparks der Welt nicht ausreichen, um relevante Mengen zu entschlüsseln. Also insofern: verschlüsselt alles, was geht. Aber bildet euch nicht ein, ihr wärt dann safe. Die Cloud ist prinzipiell ein Einfallstor für Ransomware, für Spionage und ein Risiko für Datenverlust. Wenn man sich dessen bewusst ist, kann man das nutzen.

Bezüglich der Speicherung auf HDD sehe ich das auch so, wie schon geschrieben. Man weiss, was man beachten muss.

Bezüglich Cloud sehe ich das ähnlich wie Reinhard. Es gibt sicherlich gute Verschlüsselung, bei der es auch eine angemessene Zeit dauert, die zu knacken. Aber entscheidend ist immer, wer das Verschlüsselungsverfahren entwickelt hat und zu welchem Zweck. Und zum Knacken der Verschlüsselung braucht man in der Regel nur Zeit und Rechenleistung.

Insofern bin ich bei Cloud Speicher auch sehr vorsichtig. Grundsätzlich ist die Idee, das Backup außerhalb der eigenen 4 Wände aufzubewahren, sicherlich sinnvoll. Aber das einfach in die Cloud schieben, finde ich auch schwierig. Außerdem ist da auch nicht immer bekannt, wie die es mit Datensicherheit halten. Es gab ja schon ausreichend Fälle, in denen was “versehentlich falsch konfiguriert wurde” usw. Und manche Anbieter scannen ihre Kundendaten ja auch auf “unerwünschte Inhalte”. Und wenn digitale Daten einmal weg sind, sind sie weg und beliebig kopierbar. Ist ja nicht wie bei physischen Daten, die man wiederbeschaffen kann.

Wenn man die Cloud nimmt, sollte man sein Backup auf jeden Fall lokal verschlüsseln und nur in dieser Form in die Cloud schieben.

Ich bevorzuge da lieber mehrere HDDs an verschiedenen Orten, am besten alle repliziert, so dass alle soweit möglich den gleichen Stand haben.

Danke für den Tipp, CD und DVD war mir klar, hab ich auch selbst schon gehabt. An Flashspeicher dachte ich dabei nicht.

Alles gute für 2023, bleibt gesund.

Dieter

Sorry, aber das ist einfach falsch. Rein auf mathematischer Ebene ist Verschlüsselung schon lange so sicher, daß es mit heutigen Rechnern weit mehr als ein paar Jahrzehnte dauert sie zu knacken. Der Rest ist eine Frage der Implementierung. GPG hat zwar Sicherheitslücken, aber es ist quelloffen und prinzipiell sicher, hat keine Hintertür und ist auch nicht verboten.

»Die Cloud« spielt in der ganzen Debatte einfach keine Rolle, weil das ein Begriff aus dem Reich des Bullshit-Bingos ist. Das muß man schon genauer spezifizieren. Wenn ich irgendwo einen Server miete, auf dem ich Admin bin (root), alles frisch installiere und dort verschlüsselte Daten ablege, wo soll da Ransomware herkommen?

Das Argument mit Ransomware ist überhaupt das i-Tüpfelchen. Ransomware baut ja gerade darauf, daß man verschlüsselte Daten nicht so einfach entschlüsseln kann, um Leute damit zu erpressen.

Mehr werde ich dazu nicht schreiben. Hier wurde auch mal darüber debattiert, ob DVDs oder HDDs für Backups die bessere Wahl seien. Ich war schon damals für HDDs, Du nicht. Das wird mir hier langsam zu sehr DSLR-/XYZ-Forum (ein Thema, worüber Du Dich ironischerweise neulich ebenfalls ausgelassen hast, und wo ich Dir weitestgehend zustimme).

Das ist eine Antwort auf Reinhards Kommentar: https://pen-and-tell.de/2023/01/__trashed-4/#comment-14918

GPG? Du meinst sicher PGP? Wenn es Sicherheitslücken hat, wie Du sagst, ist es nicht sicher. Weder prinzipiell noch überhaupt.

Wenn Du glaubst, Dein frisch installierter Server sei sicher, dann lies mal fefe. Sicher bedeutet, dass da keiner rankann außer Dir. Wenn da wer anders rankann, dann ist das unsicher. Ein bisschen unsicher gibt’s nicht. Und natürlich kann man mit Ransomware verschlüsselte Daten wieder entschlüsseln. Wenn man die richtige Firma beauftragt und die entsprechende Summe auf den Tisch legt. Ich bin Journalist und habe Quellen, die ich nicht offenlegen werde. Und wenn ich Dir sage, es gibt keine für den Enduser zugängliche, sichere Verschlüsselung und keine für den Enduser zugänglichen, sicheren Server, dann kannst Du mir das glauben. Oder auch nicht. Das ist mir wurst. Bezüglich DVDs: Ich habe bisher keine Ausfälle bei meinen DVD-Backups gehabt. BlueRay und CDs ja, DVDs nein. Auch nach 20 Jahren nicht. Das Problem ist, dass DVDs die heutigen Datenmengen nicht mehr darstellen können. Wenn ich vor 20 Jahren meine Daten statt auf DVDs auf damals aktuelle Festplatten -z-B- SCSI-Festplatten – gespeichert hätte, hätte ich jetzt ein Problem. Es gibt auch keine SCSI-zu-USB-Adapter mehr.

“Wenn Du glaubst, Dein frisch installierter Server sei sicher, dann lies mal fefe. Sicher bedeutet, dass da keiner rankann außer Dir. Wenn da wer anders rankann, dann ist das unsicher. Ein bisschen unsicher gibt’s nicht.”

Tja, der gute fefe …

Sicherheit ist immer (auch) eine Frage des Bedrohungsmodells. Es ist für die Zwecke der Vertraulichkeit egal, wer alles außer mir an meinen gemieteten Server rankann, wenn ich ihn nur dazu benutze, Bits zu speichern, die ich lokal auf meinem eigenen Rechner verschlüsselt habe, und dieselben Bits bei Bedarf wieder zurückzuholen. Mit den verschlüsselten Bits auf dem Server kann selbst die NSA mit sehr großer Sicherheit nichts anfangen (siehe meinen anderen Kommentar über Verschlüsselungsverfahren). Wenn andere Leute an meinen Server rankönnen, dann habe ich potentiell ein Zuverlässigkeitsproblem; vielleicht werden meine Daten ja gelöscht oder verfälscht, aber das löse ich durch Redundanz – außer Cloud-Backups auch noch lokale – bzw. kryptografische Prüfsummen. Ein Vertraulichkeitsproblem kann ich mit der gebotenen Sorgfalt vermeiden.

Ansonsten gilt natürlich, dass, falls ich wirklich ins Visier irgendwelcher Geheimdienste geraten sollte, die Vertraulichkeit meiner Cloud-Backups höchstwahrscheinlich mein geringstes Problem ist. Klassisch dazu ist XKCD Nr. 538.

IT-Sicherheit ist keine Frage des Bedrohungsmodells. Wenn ich keine Angriffe zu befürchten habe, dann brauche ich keine Sicherheit. Wenn ich welche zu befürchten habe, dann schon. Wenn es mir wurscht ist, dass Geheimdienste meine Festplatte lesen, dann brauche ich keine Verschlüsselung. Will ich das verhindern, dann brauche ich dagegen IT-Sicherheit. In der Cloud gibt es keine Sicherheit. Und solange ein PC im Netz hängt, auch nicht. Verschlüsselung hin oder her. Das ist eine Schein-Sicherheit. Sonst nichts. Potsdam hat gerade mal wieder alles physikalisch vom Netz geklemmt, weil das die einzige Möglichkeit war, Angriffe abzuwehren. Sind die alle so viel blöder als die Kommentatoren hier?

Nur für die Akten: Es gibt gängige Kryptoverfahren, die für alle praktischen Zwecke unbrechbar sind. AES-256 zum Beispiel existiert seit über 20 Jahren und es sind bisher keine – nicht mal theoretische – Angriffe bekannt, die schneller gehen als das Durchprobieren aller möglichen Schlüssel. Aber allein zum *Aufzählen* aller möglichen Schlüssel zwecks Durchprobieren bräuchte man bei AES-256 technologieunabhängig mehr Energie, als im Universum zur Verfügung steht. Wenn AES-256 korrekt implementiert und eingesetzt wird (wobei man sich im Prinzip in den Fuß schießen kann, auch wenn das Verfahren selbst OK ist), ist es sicher. Schon “normales” AES mit 128-Bit-Schlüsseln ist für die vorhersehbare Zukunft sicher genug.

Übrigens: Quantencomputer sind gefährlich für asymmetrische Kryptoverfahren, wo man z. B. sehr große Zahlen in ihre zwei – halb so großen – Primfaktoren zerlegen muss, Stichwort RSA. Deren Sicherheit beruht darauf, dass das mit herkömmlichen Mitteln bis jetzt nicht effizient möglich ist. Wenn es ums Verschlüsseln von Backups geht, wofür man kein RSA braucht, ist das aber irrelevant.

https://de.wikipedia.org/wiki/Advanced_Encryption_Standard

Mittlerweile hat sich die Welt weitergedreht…..

Erst mal vielen Dank an Reinhard für die Erinnerung sich mal wieder um seine Datensicherung zu kümmern.

Der Datenerhalt (data retention time) von flash-speicher ist von mehreren Faktoren abhängig und bei genauer Betrachtung deutlich komplizierter als z.B. der Autofokus bei Kameras von Olympus/OMDS 😉 .

Bei den Zahlen halten sich die Hersteller gerne bedeckt. Generell lässt sich aber sagen, dass die data retention time bei neueren Technologien wie 3D QLC geringer ist als bei den älteren SLC oder MLC (siehe z.B. swissbit.com „Nand-Flash im Überblick“).

In der ćt 11/2021 wurde eine data retention time von 5 – 10 Jahren (je nach Hersteller) bei 10% Abnutzung publiziert. Das passt ja auch ganz gut zu Reinhards Erfahrungen (Fotos aus 2014 unbrauchbar, aus 2018 ganz ok).

Nachdem sich die Diskussion hier in einem Bereich bewegt, der mit Flash-Speicher nichts mehr zu tun hat, mache ich hier zu. Wer über Verschlüsselungstechnologien streiten möchte, kann das gerne in einem IT-Sicherheitsforum tun.